El auge de tecnologías como la Inteligencia Artificial y el aprendizaje automático, unido a los problemas de suministro de componentes, ha abierto una fuerte competencia entre los proveedores de procesadores. En el terreno de las GPU, esta guerra cuenta con tres protagonistas principales, AMD, Intel y Nvidia, cuyos avances están marcando el presente y futuro de este mercado.

La unidad de procesamiento de gráficos (GPU) moderna comenzó como un acelerador para videojuegos de Windows pero, en los últimos 20 años se ha transformado en un procesador de servidor empresarial para aplicaciones de Inteligencia Artificial (IA) y computación de alto rendimiento.

Ahora, las GPU son una pieza clave para el rendimiento en la supercomputación, la IA, la investigación de fármacos, los modelos de previsiones financieras y otras muchas aplicaciones. También se han aplicado a tareas más comunes para situaciones en las que las CPU no son lo suficientemente rápidas, como en las bases de datos relacionales.

A medida que crece la demanda de GPU, también estamos asistiendo a un aumento de la competencia entre los proveedores que fabrican estos componentes para servidores. Se trata de un segmento en el que dos grandes nombres mantienen una fuerte pugna por liderar el mercado, AMD y Nvidia, y a los que en breve se le unirá Intel. Si bien esta ha fallado en intentos anteriores de convertirse en una alternativa a las GPU de los dos proveedores dominantes, su nuevo intento puede llegar a buen fin.

Las GPU cobran protagonismo en los centros de datos

Si hay un segmento en el que ha aumentado notablemente la demanda de GPU es en el de los centros de datos. Los proveedores son muy conscientes de esto, pero también de que se trata de una tendencia al alza que representa una oportunidad de negocio creciente.

Esto se debe a que las GPU son más adecuadas que las CPU para manejar muchos de los cálculos requeridos por la Inteligencia Artificial y el aprendizaje automático en los centros de datos.

No es que las CPU no puedan gestionar estas tareas, simplemente les lleva mucho más tiempo. Sin embargo, las GPU están diseñadas para resolver problemas matemáticos complejos en paralelo al dividirlos en tareas separadas en las que trabajan al mismo tiempo, y así los resuelven más rápidamente.

Los proveedores siguen introduciendo mejoras para avanzar en la capacidad de cálculo de las GPU

Para conseguirlo, las GPU disponen de varios núcleos, más que una CPU genérica. Por ejemplo, las CPU de servidor Xeon de Intel tienen hasta 28 núcleos, y las CPU de servidor Epyc de AMD tienen hasta 64. Por su parte, la generación actual de GPU de Nvidia, Ampere, tiene 6912 núcleos, todos funcionando en paralelo para el procesamiento matemático.

En medio de tantas cifras, los proveedores siguen introduciendo mejoras para avanzar en la capacidad de cálculo optimizando el rendimiento de las GPU, que se mide en cuántas operaciones matemáticas de coma flotante pueden realizar por segundo, o FLOPS.

Ante este panorama, ¿qué nos depara el futuro de las GPU? AMD, Intel y Nvidia ya han puesto sus cartas sobre la mesa desvelando sus planes más inmediatos y todo apunta a que la competencia será aún más dura.

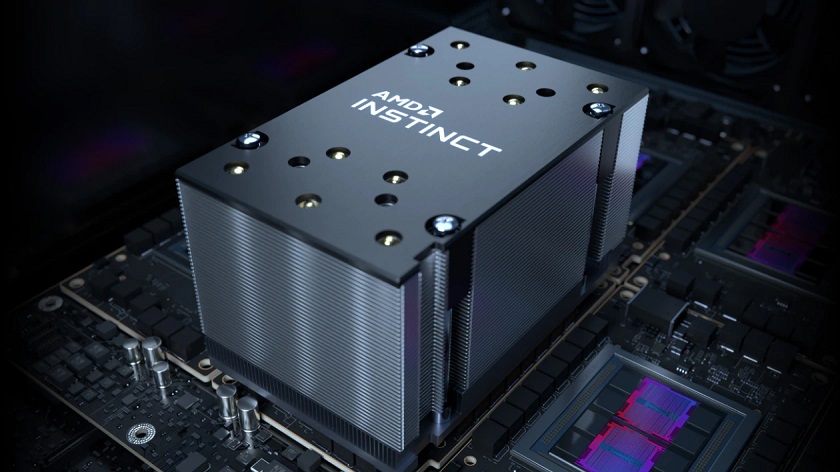

La apuesta de AMD

AMD tiene el viento a su favor. Las ventas de sus CPU x86 le están permitiendo aumentar trimestre a trimestre su cuota de mercado. Además, la compañía completó el pasado mes de febrero completó la adquisición de Xilinx en lo que se convirtió en el mayor acuerdo en la compra de chips valorado en 49.800 millones de dólares.

Con esta compra, AMD avanzaba en su objetivo de liderar la computación adaptable y de alto rendimiento, teniendo en cuenta que Xilinx era líder en FPGA, SoC adaptativos, motores de Inteligencia Artificial y una dilatada experiencia en software.

Con todo ello, este año se presenta con buenas perspectivas para la compañía. Las nuevas GPU para juegos de AMD basadas en su arquitectura RDNA 3 estarán este año en el mercado y, si bien la firma no se ha pronunciado sobre las especificaciones de RDNA 3, algunos blogs de gamers sí han hecho circular rumores de un aumento del rendimiento del 50% al 60% respecto a RDNA 2.

Mientras tanto, la compañía ha apostado por iniciar la comercialización de su línea Instinct MI250 de aceleradores GPU para computación empresarial, considerablemente más rápidos que la serie MI100 anterior.

El bus de memoria se ha duplicado de 4096 bits a 8192 bits, el ancho de banda de la memoria se ha más que duplicado, pasando de 1,23 TBps a 3,2 TBps y el rendimiento se ha más que cuadruplicado desde los 11,5 TFLOPS de FP64 a los 47,9 TFLOPS.

Daniel Newman, analista principal de Futurum Research, apunta que la oportunidad de AMD de hacerse con una mayor cuota de mercado llegará a medida que crezca el mercado de IA y su éxito en el mercado de las CPU podría ayudar a sus ventas de GPU.

AMD aprovechará su éxito en microprocesadores para impulsar las ventas de sus GPU

Desde esta consultora confían en que esto les permita aumentar significativamente la cuota de mercado de IA/HPC porque AMD siempre ha sabido encontrar oportunidades de mercado y gestionar su cadena de suministro para cumplir con sus objetivos.

Desde Omdia también apuntan que AMD aprovechará su éxito en microprocesadores para ampliar su presencia en el mercado e impulsar las ventas de sus Instinct. Para ello está contando con sus partners OEM que ya están incluyendo Instinct en sus productos como son Asus, Atos, Dell Technologies, Gigabyte, Hewlett Packard Enterprise (HPE), Lenovo, Penguin Computing y Supermicro.

Nvidia pisa fuerte con Hopper

Nvidia presentó su hoja de ruta para las GPU el pasado mes de marzo con el anuncio de su arquitectura GPU Hopper, afirmando que, dependiendo del uso, puede ofrecer de tres a seis veces el rendimiento de su arquitectura anterior, Ampere.

Con Hopper H100 alcanzará un máximo de 60TFLOPS de rendimiento FP64.

Al igual que las GPU anteriores, la GPU Hopper H100 puede funcionar como un procesador independiente que se ejecuta en una placa PCI Express adicional en un servidor. Pero Nvidia también lo emparejará con una CPU en un procesador ARM personalizado llamado Grace que espera tener disponible en 2023.

Junto con Hopper, Nvidia también anunció NVLink 4, su última interconexión de GPU a GPU. NVLink 4C2C permite que las GPU Hopper se comuniquen entre sí directamente con un ancho de banda total máximo de 900 GB, siete veces más rápido que si se conectaran a través de un bus PCIe Gen5.

Nvidia ha sincronizado con Hopper los tres componentes clave de los centros de datos

Según apuntan desde Jon Peddie Research, la memoria, el procesador y las comunicaciones son tres componentes clave de los centros de datos que deben evolucionar al mismo tiempo, cosa que Nvidia ha conseguido al sincronizarlas con Hopper.

Nvidia planea empezar la comercialización de la GPU Hopper a partir del tercer trimestre de 2022 con sus partners OEM, incluyendo Atos, BOXX Technologies, Cisco, Dell Technologies, Fujitsu, GIGABYTE, H3C, Hewlett Packard Enterprise, Inspur, Lenovo, Nettrix y Supermicro.

Debido a las continuas presiones de suministro en su fabricante de chips TSMC, Nvidia abrió la puerta a la posibilidad de trabajar con el negocio de fundición de Intel, pero aseguró que ese acuerdo aún tardaría años en llegar.

Intel rompe el binomio dominante

Intel ha luchado durante mucho tiempo para hacer cualquier cosa que no sean GPU integradas básicas para sus CPU de sobremesa Para equipos de sobremesa cuenta con su nueva línea Intel Xe, mientras que el servidor equivalente se conoce como Intel Server GPU.

Pero la compañía volverá a hacer su incursión en el mercado de las GPU este año con un procesador con nombre en código Ponte Vecchio que cuenta con 45 TFLOPS en FP64, casi lo mismo que el MI250 de AMD y un 25% por detrás del Hopper de Nvidia.

Para los analistas, este anuncio sacudirá el mercado, si bien apuntan que la verdadera oportunidad para Intel está en su estrategia de software oneAPI.

oneAPI es una plataforma unificadora de desarrollo de software en la que está trabajando la compañía y que está diseñada para elegir el tipo de silicio más apropiado que fabrica Intel (procesadores x86, GPU, FPGA, AI) al compilar aplicaciones en lugar de obligar al desarrollador a elegir un tipo de silicio. y codificarlo.

Esta evolución del kit de herramientas para desarrolladores, también proporciona una serie de bibliotecas API para funciones como procesamiento de video, comunicaciones, análisis y redes neuronales. Con ello se elimina la necesidad de determinar cuál es el mejor procesador para cada objetivo, así como la necesidad de trabajar con diferentes herramientas, bibliotecas y lenguajes de programación.

De esta forma, en lugar de codificar para un procesador específico en un lenguaje específico, los desarrolladores pueden enfocarse en la lógica comercial y escribir en Data Parallel C++ (DPC++), una variante de código abierto de C++ diseñada específicamente para el paralelismo de datos y la programación heterogénea.

La fabricación de Intel de sus propios chips le da un mayor control sobre su propia fabricación

Uno de los grandes factores diferenciales entre Intel y sus dos grandes rivales, AMD y Nvidia, radica en dónde fabrica sus chips. Mientras que los demás hacen uso del fabricante taiwanés TSMC, Intel fabrica muchos de sus propios chips en Estados Unidos, y lo complementa con otras fábricas en Irlanda, Malasia e Israel.

Además, la compañía ya ha anunciado sus planes para construir más fábricas en Estados Unidos para así incrementar su capacidad de producción. Eso le da ciertas ventajas al tener un mayor control sobre su propia fabricación, lo cual es un gran activo de la empresa.

Al final, la competencia entre AMD, Intel y Nvidia podría reducirse a una carrera de software. Quién será el ganador dependerá de muchos factores y de cómo evolucionen estos planes a lo largo de este año, y los venideros. Estaremos atentos.

Imagen inicial | Timothy Dykes